Techno | Améliorez la performance de vos envois emailings avec l’A/B Testing

[addthis tool= »addthis_inline_share_toolbox »]

Vous avez besoin de mieux comprendre comment certains éléments influencent le comportement de vos utilisateurs ? De vérifier des hypothèses en identifiant si les changements apportés ont eu un impact dans le résultat de vos campagnes ? D’améliorer efficacement les résultats de vos envois Marketing en capitalisant sur les choix textuels ou graphiques qui montrent les meilleures performances ?

Voilà les raisons pour lesquelles les tests A/B, une méthode simple mais très efficace, ont déjà fait leurs preuves ! C’est donc en toute logique qu’ils font leur entrée sur la plateforme Email, SMS & Marketing Automation Campaign by Dolist.

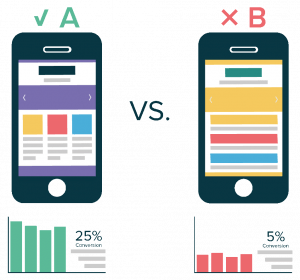

Qu’est-ce que l’A/B Testing ?

Couramment employé dans l’univers du Marketing Digital, l’A/B Testing repose sur la comparaison de vos campagnes emails de deux versions ou plus dont l’une d’elle a subi des modifications : 39% des entreprises l’exploitent sur les lignes d’objet, 37% sur le contenu du message, 36% sur la date et l’heure de l’envoi et 23% sur le pré-header*. Il est bien sûr possible de créer une ou plusieurs variables pour déterminer laquelle est la plus efficace et obtient le plus de résultats auprès des panels utilisateurs.

Lorsque plusieurs variables sont testées au sein d’un email (changement de plusieurs éléments au sein du message donnant lieu a plusieurs déclinaisons), on parle de tests multivariés ou split testing. À savoir que 77% des marketeurs en font déjà usage sur leurs sites web, leurs landings pages (60%) ou encore leurs emails (59%)*.

Dans le contexte de l’emailing, les résultats de l’A/B Testing seront en particulier mesurables sur les taux d’ouverture et de clic.

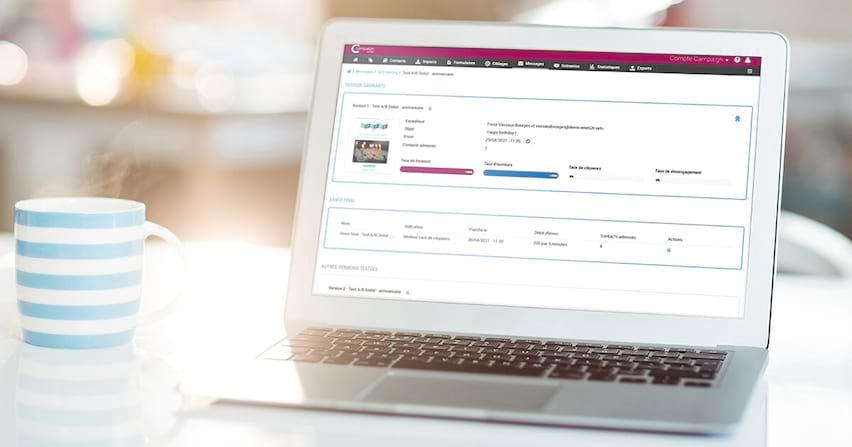

A/B Testing : la nouvelle fonctionnalité de Campaign by Dolist pour optimiser vos performances

Avec la plateforme Email, SMS & Marketing Automation Campaign, vous pouvez désormais tester jusqu’à 5 versions différentes de votre message email. Un paramétrage qui se fait en 4 étapes pour faciliter la prise en main des utilisateurs :

- Définition du nom de l’A/B Test

- Sélection des messages à tester (entre 2 et 5 messages différents)

- Définition du ciblage et de l’échantillon test (correspond à un % du ciblage prédéfini sur lequel adresser aléatoirement les différents messages à tester)

- Planification des envois (dates et heures d’envoi des tests)

Pour l’envoi final, les utilisateurs peuvent choisir entre deux méthodes de gestion :

* Invesp 2019 ; Litmus 2018

Infographie | Marronniers de fin d’année : de l’animation email ludique et différenciante pour vos contacts

Podcast « On s’mail de tout » : La DILCRAH fidélise son audience grâce à l’optimisation de sa newsletter conçue sur Campaign